L'Intelligenza Artificiale (AI) sta trasformando il mondo a un ritmo senza precedenti, dall'accelerazione della ricerca scientifica alla ridefinizione dei servizi digitali. Tuttavia, dietro la sua crescente sofisticazione e diffusione si nasconde una preoccupazione critica e in rapida espansione: l'elevato e crescente consumo di energia necessario per addestrare ed eseguire i suoi modelli più potenti. Mentre i progressi nel machine learning continuano a stupire, l'impatto di questa tecnologia sulla rete elettrica globale e sulle emissioni di carbonio solleva interrogativi urgenti sulla sua sostenibilità a lungo termine. Questo articolo esplora alcuni contributi di esperti che esaminano le principali fonti di questo fabbisogno energetico e analizza le sfide ambientali che ne derivano, con l’obiettivo di promuovere una visione critica dell'argomento, incoraggiando l'acquisizione di informazioni qualificate, evitando al contempo allarmismi infondati e semplificazioni eccessive.

Il mio punto di partenza è stato il report di Google di agosto 2025 “Measuring the environmental impact of delivering AI at Google Scale” per una misurazione dell’impatto ambientale dell’AI, in particolare di Gemini, considerata la sua pervadente e dilagante presenza, in quanto questi potenti modelli vengono ormai integrati in moltissime applicazioni, dai motori di ricerca ai sistemi di posta elettronica.

E’ stato utile consultare anche il commento che Google ha pubblicato immediatamente dopo la pubblicazione del report: “How much energy does Google’s AI use? We did the math” e l’articolo pubblicato on line su “Rivista.AI” (piattaforma gestita da Google) sempre ad Agosto 2025: “Google e il mito dell’energia: l’intelligenza artificiale non sta divorando il pianeta”.

L'azienda sottolinea che le loro stime sono significativamente più basse di molte proiezioni pubbliche, la questione si concentra principalmente sul consumo di energia, sulle emissioni di carbonio e sull'uso dell'acqua, derivanti dall'addestramento e dall'inferenza (l'utilizzo) dei modelli di AI nei data center.

L’affermazione più “di impatto” contenuta nell’articolo è quella secondo la quale una singola richiesta a Gemini, consuma appunto solo 0.24 wattora, come guardare la TV per nove secondi, emette 0.03 grammi di CO₂, come un’email, e utilizza 0.26 millilitri d’acqua, circa cinque gocce.

Certo si può pensare che essendo il report di Google su Google, potrebbe non essere imparziale e dunque sottostimare l’impatto, nonostante nell’articolo si sostenga che la metodologia considerata per il calcolo adotti l'approccio più completo per misurare il consumo energetico dell'AI.

L’articolo di Rivista.AI si rivela più obiettivo poiché contiene riferimenti a notizie diffuse su quotidiani come il Financial Times che ammonisce in un articolo di maggio 2025: “Non sappiamo ancora quanto energia consumi davvero l’AI”, sottolineando che ogni query, ogni immagine generata, incrementa la pressione energetica globale. Le previsioni parlano di un raddoppio dei consumi entro il 2030 a oltre 945 TWh, mentre le big tech vengono criticate per tentativi di riscrivere le regole del net zero, mascherando impatti reali tramite consumo di energia rinnovabile locale.

Per tentare di ottenere maggiore obiettività e imparzialità, ho cercato informazioni provenienti da altre fonti, per esempio l’articolo pubblicato sulla rivista digitale “MIT Technology Review” di dicembre 2023: “AI’s carbon footprint is bigger than you think” scritto durante i colloqui sul clima COP28 del 2024 delle Nazioni Unite a Dubai, dove si afferma che generare un'immagine richiede la stessa energia necessaria per caricare completamente uno smartphone.

Quest’ultimo articolo è precedente al report di Google e afferma precisamente che le grandi aziende tecnologiche non divulgano l'impronta di carbonio relativa all'addestramento e all'uso dei loro modelli massivi, e non disponiamo di metodi standardizzati per misurare le emissioni causate dall'IA, mentre sappiamo che l'addestramento dei modelli di IA è altamente inquinante, finora le emissioni attribuibili all'utilizzo dell'IA sono state un tassello mancante.

Viene da pensare che il report di Google sia stato realizzato proprio per colmare questa carenza di trasparenza da parte delle grandi aziende tecnologiche sui propri consumi.

Un altro articolo interessante per capire le informazioni presenti nel report di Google è quello pubblicato sull’autorevole rivista “Wired” ad agosto 2025, “Gemini, quanta energia consuma il sistema di AI? Google ha deciso di fare i conti”, che tuttavia presenta i contenuti del report senza farne un commento critico. Possiamo però trovare un commento molto più illuminante nell’intervento del Prof. Zecchina “Che cosa è l'intelligenza artificiale oggi?” all’evento di Wired Italia The Big Interview, che si è tenuto il 26 giugno all’Università Bocconi di Milano.

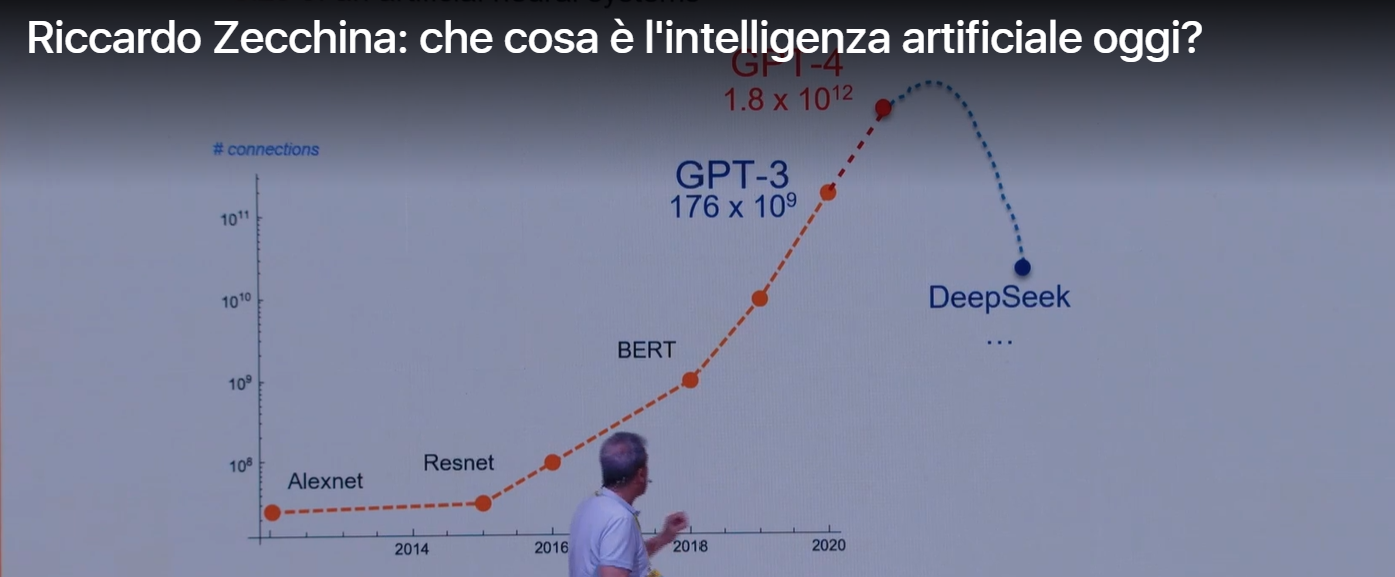

L’argomento di questo intervento è l’AI in generale, ed è veramente consigliabile seguirlo per il suo contributo alla comprensione di cosa sia e come si sta sviluppando l’AI. Proprio nella prima parte del suo intervento Zecchina si concentra sulla natura energivora dell’AI e sui possibili sviluppi futuri. Trascrivo direttamente dal suo intervento “Un punto molto importante da capire, proprio per dare un po' di solidità a queste osservazioni sulle risorse necessarie per far funzionare questi sistemi, è quanto sono grandi. Quanto sono grandi i sistemi di intelligenza artificiale? Quanto è grande ChatGPT? E il sistema che sta dietro a ChatGPT? Se noi lo vediamo nella prospettiva storica, vediamo che all'inizio dell'era moderna dell'intelligenza artificiale, diciamo nel 2012, le reti neurali artificiali avevano qualche milione di parametri che venivano regolati dagli algoritmi di apprendimento. Al variare del tempo, quello che hanno visto i ricercatori seguendo le leggi di scala, è che creando sistemi sempre più grandi le prestazioni aumentavano notevolmente e quindi questo ha portato le aziende a investire un sacco di soldi, a creare dei sistemi mostruosi, nel senso che oggi GPT4 ha circa mille miliardi di parametri. Voi capite che fare il training, cioè presentare dei dati a un sistema di questo genere in modo che questo possa apprendere e sia in grado di fare tutta una serie di operazioni interessanti come quelle che osserviamo tutti i giorni, costa una quantità di energia enorme. C'è bisogno di centri di calcolo che ad esempio in Italia sostanzialmente non abbiamo.“

Da tutte queste informazioni mi sento di dire che è vero che le aziende che si occupano di tecnologia sono ancora troppo poco trasparenti per quanto riguarda l’energia necessaria a farle funzionare e che servono standard, audit e metriche globali in modo da poter confrontare le prestazioni. La cosa positiva è che Google ha cominciato a pubblicare i dati che intende rendere pubblici e questo potrebbe generare un processo virtuoso che può coinvolgere anche le altre aziende. Ho capito però che non basta dire che ogni prompt dell’utente richiede in proporzione poca energia: il vero impatto emerge nella somma di tutti i prompt, anche considerando quelli di cui non siamo coscienti e che sono integrati nei motori di ricerca e nei sistemi di posta elettronica per esempio.

Mi ha colpita una frase che ho letto in uno degli articoli che ho citato “ottimizzare l’AI non basta, bisogna governarla”.